2016点击型号即可查看芯片规格书

10100点击型号即可查看芯片规格书

量子计算机能够解决某些传统计算机无法有效解决问题的状态,就被称为「量子至上」。

一文告诉你,谷歌是否真的实现了「量子至上」

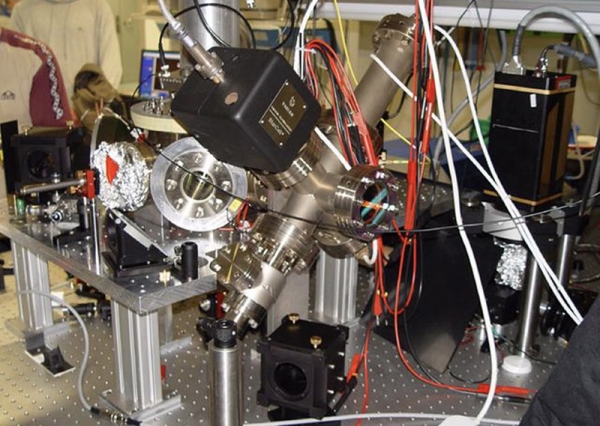

▲ 量子计算机系统中的一个组成部分(稀释制冷机),这张照片拍摄于2016年的一间无尘运行室。如果量子计算机真的能够以超越传统计算机的速度与效率完成某种计算,那么“量子至上”目标就算是真正达成。但是,这项目标本身并不能帮助我们实现一切关于量子计算的发展梦想。

在刚刚过去的9月份,有一条爆炸性新闻披露:作为致力于量子计算研发的全球科技巨头之一,谷歌公司宣称其刚刚实现了“量子至上”目标。尽管现在经典计算机(包括笔记本电脑、智能手机甚至是现代超级计算机)已经非常强大,但不少科学问题当中包含的复杂性仍然无法被解决。

而如果我们能够构建起功能更为强大的量子计算机,则可以利用它解决一系列经典计算机所无法解决的难题。这种通过量子计算机解决某些传统计算机无法有效解决问题的状态,就被称为「量子至上」。那么,谷歌真的做到了吗?我们将通过研究,逐步找出答案。

>>> 经典计算机与量子计算机的区别

一文告诉你,谷歌是否真的实现了「量子至上」

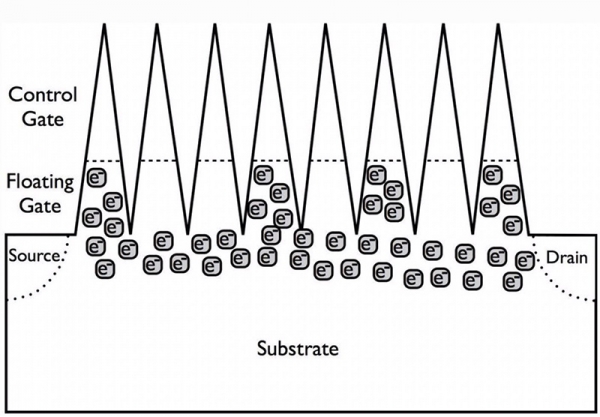

▲ 如今,固态存储设备的基本工作原理,在于通过抵制或者允许带电粒子穿过基板/栅极以产生电流流动,从而表达0或1这一编码结果。原则上,我们也可以通过将栅极替换为永久电荷的方式将传统比特转化为量子比特,但量子比特的瞬态不再为0或1,而是两种状态叠加共存。

经典计算机的概念非常简单,最早可以追溯到阿兰·图灵最早提出的图灵机模型。通过将信息编码为比特(即0和1),我们就可以对这些比特进行一系列运算(例如AND、OR、NOT等),并以此为基础执行任意其他计算。但是,其中某些计算易于实现,而有一些则难度极高。当然,从理论上讲,只要我们能够设计出一种与计算需求相对应的算法,那么无论其需要占用多少计算资源,我们都可以把它编程至经典计算机当中。

不过问题在于,量子计算机的基本原理与经典计算机有所不同。量子计算机使用量子比特或者普通比特的量子模拟,用以替代通常仅能为0或者为1的普通比特。这种颠覆性的设计理念,意味着我们要想迈入量子时代,就必须对经典时代所熟知的特定物理原理加以转变。

一文告诉你,谷歌是否真的实现了「量子至上」

▲ 这套离子阱设计方案主要基于Wolfgang Paul的工作成果,也是量子计算机应用离子阱技术的早期实例之一。这张照片拍摄于2005年位于奥地利因斯布鲁克的一个实验室,其中展示的是目前已经过时的一台早期量子计算机的组件之一。离子阱计算机的计算速度远远不及超导量子比特计算机,但其相干时间在尺度上则更长,因此维持计算稳定性的难度也就更低。

量子比特不会被永久记录为明确的0或者1,而代表着一种二态量子力学系统,其中基态代表0,激发态则代表1。(例如,电子可以以向上或者向下两种方式维持自旋;光子可以在其极化方向上进行左旋或者右旋等。)在进行系统初始准备以及读取最终结果时,量子比特的值也只会显示为0与1,这一点与经典计算机中的普通比特完全一致。

其中最大的区别在于,执行实际计算操作时,量子比特并非处于确定的状态,而是表现出0与1的叠加态:类似于薛定谔提出的既生又死的猫。只有当计算结束并读取最终结果时,我们才能够得到唯一一个真正的最终状态值。

一文告诉你,谷歌是否真的实现了「量子至上」

▲ 在薛定谔提出的经典实验中,我们并不知道小猫是否因量子衰变而被杀死。具体来讲,盒子中小猫的生死取决于放射性粒子是否衰变。如果这代表着一套真正的量子系统,那么小猫本身既非生也非死,而是处于两种状态的叠加,直到实验者对结果进行直接观察。

经典计算机与量子计算机之间存在着巨大的差别,包括预测、确定性与概率。与一切其他量子力学系统一样,我们无法简单为量子系统提供初始条件以及可供其运行的算法运算符,从而准确预测出最终状态。相反,我们只能先预测最终状态的概率分布,然后通过反复的关键实验,得出匹配并产生这一预期结果的分布趋势。

很多人可能觉得,要想模拟量子活动,必须要使用量子计算机——其实并不一定。我们可以在量子计算机上模拟量子活动,也可以在图灵机(即经典计算机)上实现相同的效果。

一文告诉你,谷歌是否真的实现了「量子至上」

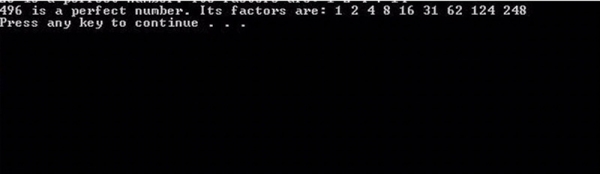

▲ 在拥有充足计算能力的前提下,计算机程序也可以利用经典(非量子)计算机上的无缺陷运行算法,对候选的梅森素数进行暴力分析,从而查看其是否与理想数相对应。对于较小的数字,这种运算能够轻松实现;但对于规模庞大的计算任务来说,其难度则极高,而且需要消耗巨大的算力。

这也是计算机科学当中最重要的思想成果之一:邱奇-图灵理论。这一理论指出,只要某个问题能够由图灵机解决,那么该问题也一定可以通过其他任何计算设备解决。这种计算设备可以是笔记本电脑、智能手机、超级计算机甚至是量子计算机。换句话说,在某一计算设备上能够解决的问题,应该可以在一切计算设备上得到解决。这话绝对没错,只是其中没有提到该问题的计算速度或者效率,也没有体现任何关于量子至上理论的信息。

与此同时,其中还存在着另一个更具争议性的问题,即对邱奇-图灵理论的扩展。该理论指出,图灵机(例如经典计算机)能够始终有效模拟任何计算模型,甚至模拟固有的量子计算过程。而如果我们能够对此提出一个反例——例如演示一个例子,证明量子计算机的执行效率要远远高于经典计算机,则意味着“量子至上”得到了直接证明。

一文告诉你,谷歌是否真的实现了「量子至上」

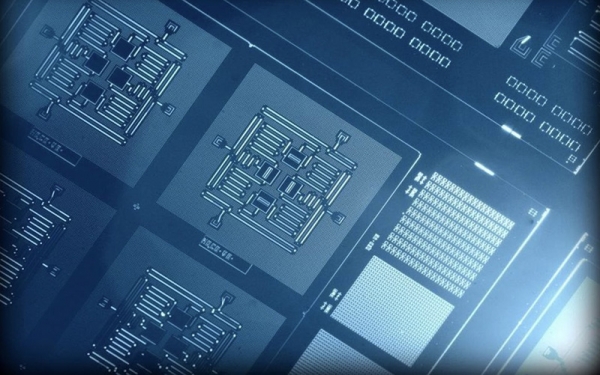

▲IBM公司的四量子比特方电路堪称计算领域的先驱,有朝一日功能强大的量子计算机也许足以模拟整个宇宙。但是,目前量子计算领域仍处于起步阶段,因此在任何限制条件下证明量子至上,在当下都是一个了不起的里程碑。

这也是目前众多科研人员和科技巨头正在为之各自努力的共同目标:设计出一种量子计算机,至少能够在某一可重现的条件下显著超越经典计算机。那么,要如何实现这个目标?其中的关键,可以简单概括成——在经典计算机当中,我们可以对任何信息比特(或者比特组合)执行多种经典运算,包括大家所熟知的AND、OR以及NOT等运算。

但如果我们拥有的是一台量子计算机,那么其中提供的量子比特就能够在经典运算之外,执行一系列纯量子运算。这些量子运算遵循能够在经典计算机上模拟的特定规则,但却不必像后者那样承担巨大的计算成本代价。与此同时,所有运算过程都能够在量子计算机上实现轻松模拟,且与量子比特的相干时长相比,执行所有计算操作所需要的时间都将大大缩短。

一文告诉你,谷歌是否真的实现了「量子至上」

▲ 在量子计算机当中,处于激发态(状态为「1」)的量子比特将在所谓相干时间这一时间尺度上误差回基态(状态为「0」)。如果量子比特之一在执行所有计算之前发生衰减,而我们又读取了它给出的结果,则会产生错误。

>>> 谷歌:以特定的协议尝试实现“量子至上”

考虑到这一点,谷歌团队在NASA网站上发表了一篇论文(可能是最终版本的早期草稿),但随后又将其删除,导致很多科学家还没来得及阅读并下载。虽然尚未弄清文章中所提到的全部含义,但我们可以通过以下方式想象他们采取的解决方法。

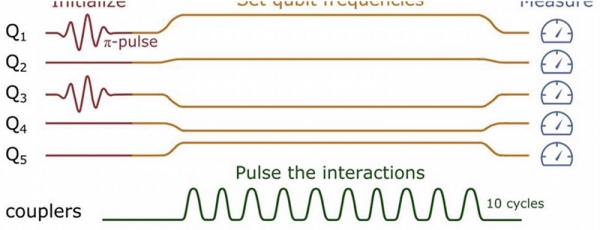

这里,我们想象自己拥有5个比特或者量子比特信息,全部为0或者1。这些状态都以0作为起点,但我们为其准备了一种新状态,其中有两个比特/量子比特被激发为“1”状态。如果完全控制了这些比特或者量子比特,则能够以显式方式实现状态准备。例如,我们可以将1号比特与3号比特激发为1。在这种情况下,系统的物理状态将表现为|10100>。接下来,大家可以通过脉冲随机操作对这些比特/量子比特进行操纵,从而得到特定的概率分布结果。

一文告诉你,谷歌是否真的实现了「量子至上」

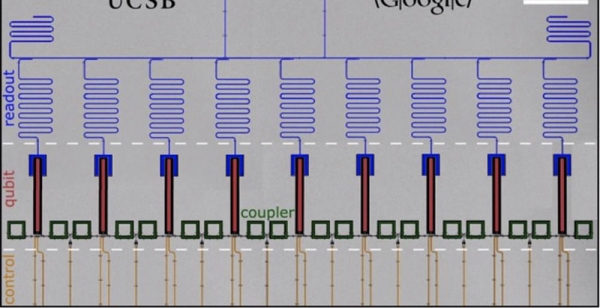

▲ 一个9量子比特量子电路,由显微镜成像并进行标记。灰色部分为铝底板,深色区域则为表面铝材质被蚀刻后的部分,各种颜色用于区分不同的电路元件。对于使用超导量子比特的此类计算机,设备本身必须在毫开尔文级温度下保持极低温状态,且以远低于50微秒的时间尺度之上运行,只有这样量子计算才可能实现。

谷歌团队在实验当中选择了一种特定的协议以尝试实现“量子至上”,其中的要求是在执行任意数量的运算之后,已被激发的比特/量子比特(也就是状态为「1」的比特)数量必须保持不变。这些运算是完全随机的,意味着我们不需要限定具体是哪些比特/量子比特处于激发态(1)或者基态(0);总之,我们只需要在5个量子比特当中获得2个“1”状态比特与3个“0”状态比特就行。如果我们不完全执行随机操作,且不在计算机上以纯量子运算的编程方式实现,那么预计5个量子比特所表现出的10个潜在最终状态将以均匀概率分布。

(这10种可能的结果分别为|11000>, |10100>, |10010>, |10001>, |01100>, |01010>, |01001>, |00110>, |00101>以及|00011>。)

但是,如果我们的量子计算机严格遵循我们对于量子计算设备的定义,那么得到的概率分布实际上并不均匀。相反,某些状态会在最终状态结果中以更高的频度出现,而其他一些状态则较少出现。这是一种非常典型的反直觉结果,源自量子现象以及纯量子门的自身特性。我们也可以利用经典计算机模拟这种现象,只是需要投入巨大的计算成本。

一文告诉你,谷歌是否真的实现了「量子至上」

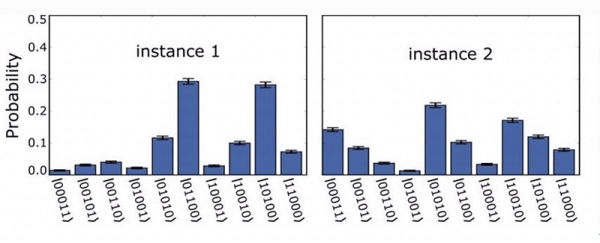

▲ 当我们以|10100>量子比特状态为起点执行实验,并经过10次耦合脉冲(即量子运算)之后,对于这10种可能结果中的每一种,我们得到的并不是具有均等概率的均匀分布;相反,某些结果将具有异常高的出现概率,而某些结果的出现概率则极低。对量子计算机的结果进行衡量,即可确定我们能够维持符合预期的量子活动,亦或是已经在实验当中失控。

在量子计算机上,即使仅使用经典比特门,我们仍然无法彻底消除量子效应。但是我们可以清楚地看到,实际获得的概率分布并不均匀,某些可能状态的发生机率显著高于直观预测中的10%,而某一些则低于10%。这些超低与超高概率状态的存在纯粹属于量子现象,而获得这些低概率与高概率结果(而非均匀分布)的几率本身,则是量子活动的重要存在标志。

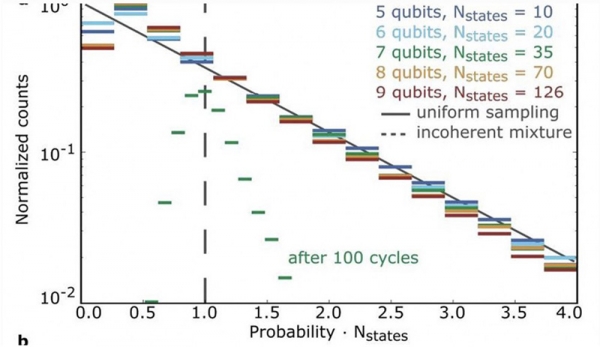

在量子计算领域,获得至少一个表现出极低出现概率的最终状态的几率,同样遵循特定的概率分布,即波特-托马斯分布。如果您的量子计算机完美无瑕、运作良好,那么您将可以根据需求执行任意多次损伤,而后读取结果以查看您的计算机是否符合预期的波特-托马斯分布。

一文告诉你,谷歌是否真的实现了「量子至上」

▲ 波特-托马斯分布,图中所示为第5、6、7、8、9量子比特在特定量子比特数量与可能状态下得出某些运算结果的概率。请注意其中的直线,其代表预期的量子结果。如果运行量子电路所需要的总时间过长,则会得出与经典计算机一致的结果:以短绿线为例,这显然不符合波特-托马斯分布。

但实际上,我们目前的量子计算机还远称不上完美无瑕。任何量子系统,无论经过怎样全面的筹备(谷歌团队使用超导量子比特,但大家也可以使用其他量子计算机,例如量子点或者离子阱式计算机),相干时间仍将存在:在这一时间周期之内,我们可以期望特定量子比特能够一直保持激发态(即1)。而一旦超过该时间,其将衰减回基态0。

这一点非常重要,意味着将量子运算应用于实际系统必须严格把控时间周期,即门时间。在相干时间尺度之内,门时间必须非常短,否则所测量的状态就可能发生衰减,而且最终状态无法提供我们所需要的结果。同样的,拥有的量子比特越多,设备的复杂性就越大,而各个量子比特之间发生错误串扰的可能性也就越高。为了构建一台无错量子计算机,我们必须在系统崩溃之前,将所有量子门应用于所有量子比特。

超导量子比特目前仅能保持50微秒的稳定周期。而即使是在约20纳秒的门时间条件下,周期内所能稳定执行的计算也就只有几十次,而退相干会迅速破坏实验环境并带来恐怖的均匀分布结果——换言之,我们努力追求的量子活动将瞬间消失。

▲ 理想的5量子比特设置,其中初始电路利用2个初始状态为1以及3个初始状态为0的量子比特准备而成,其产生最终状态结果之前需要经历10次独立的脉冲(或者说量子门)。如果通过量子门所耗费的总时间比系统的相干/退相干周期短得多,那么我们就能够获得与预期相符的量子计算结果。而如果没有,我们就无法在这台量子计算机上执行有意义的计算操作。

问题在于,无论从哪个角度来看,谷歌科学家们利用其53量子比特计算机解决的问题都不能算是实际问题。事实上,这套系统设置经过了专门设计,能够执行一项对于量子计算机而言非常容易、但对经典计算机来说却需要消耗大量算力的任务。他们采用的方法是构建一套n量子比特系统(在经典计算机上至少需要2n数量级的普通比特才能进行模拟),然后选择一种对经典计算机而言计算成本尽可能高的运算任务。

由科学家们(包括谷歌团队的多位现任成员)提出的原始算法,至少需要一台72量子比特的量子计算机才能完成量子至上理论的证明。但由于72量子比特尚无实现可能性,所以大家不得不退回53量子比特计算机,同时引入另一个量子门(fSim门,属于CZ同iSWAP门的结合体)替代原本易于模拟的量子门CZ(fSim门在经典计算机上的执行成本相对更高)。

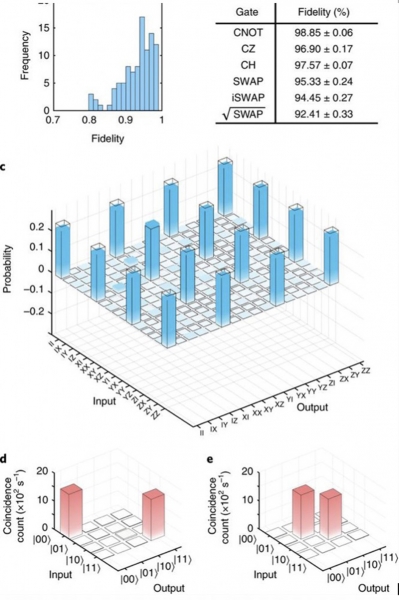

▲ 不同类型的量子门根据具体类型表现出不同的保真度(即无错门的百分比),同时也能体现出经典计算机在处理此类任务时需要的极高算力消耗。量子至上证明实验最初尝试使用CZ门,但研究人员发现至少需要72量子比特设备才能完成;他们随后采用iSWAP门,使得谷歌团队仅使用53量子比特就证明了这一理论。

很多邱奇-图灵理论的支持者都抱持着这样一个希望,即只要存在某种足够先进的算法,我们也能够在经典计算机上显著减少此类问题的计算时间。虽然概率不高,但这确实意味着目前的“量子至上”成就仍然存在着一丝丝崩溃的可能。

不过到目前为止,谷歌团队似乎确实通过解决某一特殊的(并无实用性)数学问题,从而首次实现了“量子至上”。他们使用量子计算机执行这项任务时,其速度表现甚至远远超过目前美国最为强大的经典超级计算机。但是,真正具备实用性的量子至上目标应该能够帮助我们完成以下三项工作:进行高性能量子化学与量子物理学计算;利用高级量子计算机取代所有经典计算机;面向任意数量的数字运行舒尔算法。

换句话说,量子至上时代可能已经到来,但实用的量子至上能力仍然远远没有实现。例如,如果我们想要分解一个长度为20位的半质数,那么谷歌的量子计算机根本就无能为力。但是,现有笔记本电脑已经能够在几毫秒之内完成这项运算。

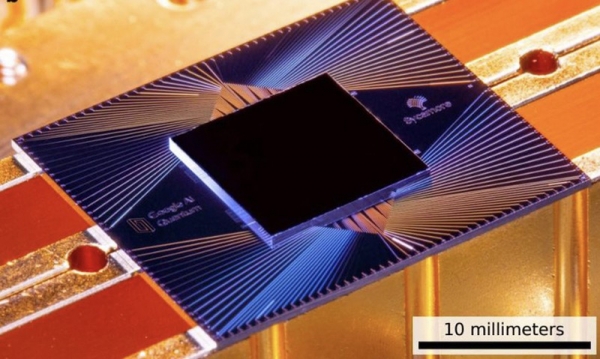

▲ Sycamore处理器是一个包含54量子比特的矩形阵列,各量子比特通过耦合器与邻近的4个量子比特相连,其中包含一个不可操作的量子比特。通过这种结构,谷歌构建起一套实际有效量子比特为53个的量子计算机。通过上图,我们可以看到光学条件下的Sycamore芯片尺寸与呈现出的颜色。

量子计算领域的进步令人震惊,虽然仍有批评者对此不屑一顾,但数量级更高的量子比特系统无疑将不断涌现。在出现成功的量子纠错机制之后(无疑需要利用更多量子比特进行纠错,同时解决其他一系列复杂的问题),我们将能够显著延长相干时间尺度并执行更深层次的计算。

正如谷歌团队在公布结果时指出:“我们的实验表明,可能确实存在不符合邱奇-图灵论文的计算模型。我们已经利用物理实现式量子处理器(具有足够低的错误率)在多项式时间测试中执行了随机量子电路采样任务——这项任务在经典计算机当中尚不存在有效的解决方法。”

随着第一台可编程量子计算机的诞生,我们终于能够以有效方式利用量子比特处理令经典计算机束手无策的特定任务,而量子至上也由此得到证明。谷歌团队肯定会在今年晚些时候发布更为详尽的实验结果,也将因为这项非凡的成就而得到赞誉与掌声。

但我们也必须承认,时至今日,我们距离终极量子计算之梦仍然遥遥无期。如果想要缩短这段探索之路,我们需要竭尽全力推动前沿发展,从而最终实现这个当下最为重要(甚至没有之一)的技术目标。